作者:佚名 时间:2024-06-18 21:09:52

数据与智能,本公众号关注大数据与人工智能技术。由一批具备多年实战经验的技术极客参与运营管理,持续输出大数据、数据分析、推荐系统、机器学习、人工智能等方向的原创文章,每周至少输出10篇精品原创。同时,我们会关注和分享大数据与人工智能行业动态。欢迎关注。

作者:stephenDC

导语

机器学习中模型参数的求解,是通过优化器实现的,因此优化器也是机器学习问题的重要组成部分。不同的优化器,实现原理不同,适用场景也不同。粗略来分,优化器有适合离线使用的和适合在线使用的。

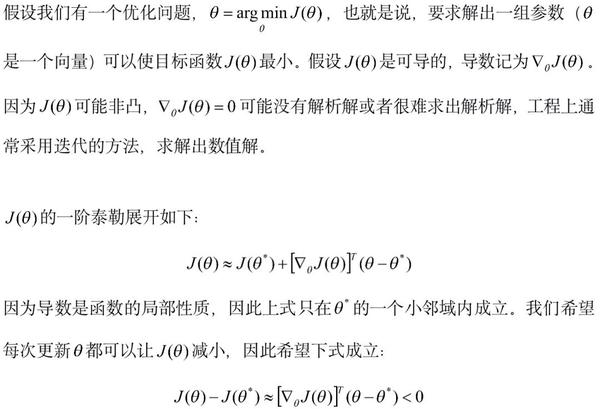

本文从梯度下降的导出开始,介绍一下离线常用的优化器,其主要内容来自于Sebastian Ruder的一篇综述。原文是英文写的,内容非常详尽,有想了解更多的可以点击文末的阅读原文。

Note:梯度下降基于目标函数的导数这一局部性质,因此梯度下降只在局部是有效的。想象一下,有一个盲人,想要下山。因为是盲人,他无法看到地形的全貌,但他手里有一台仪器,可以得到任意一处位置的地形,因此可以知道在某个点往哪个方向高度是在减小的。另外,我们假设他可以无视地形,也就是说他在移动过程中无论遇到悬崖还是峭壁,都可以不受影响地往这个方向移动任意距离。这就是所谓的梯度下降了,而我们想要解决的问题是,怎么样可以让这位盲人最快地到达山底? 、梯度下降的不同形式

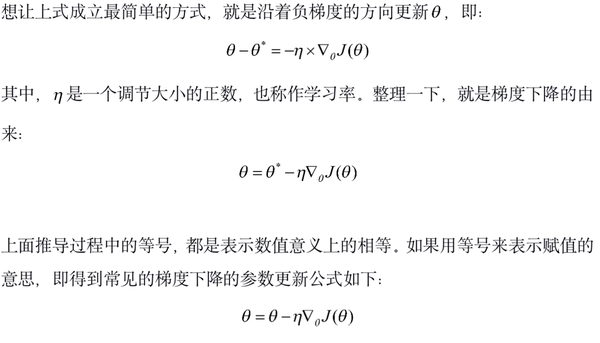

梯度下降在具体使用的时候,根据每次使用的样本数量多少,分为以下三种形式。批量梯度下降,使用全部样本计算梯度,然后更新参数,稳定性好但计算量太大;随机梯度下降,一次只使用一个样本,优点是快,缺点是稳定性差;小批量梯度下降,一次使用n个样本,是两者的折中。

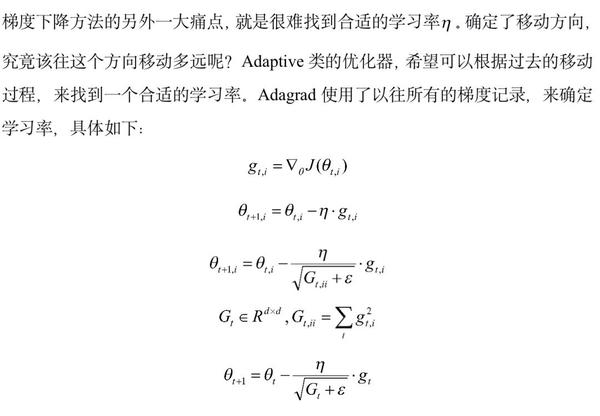

梯度下降的不足1.选择一个合适的学习率很难。学习率太大,优化的目标函数容易发散;太小,收敛很慢。2.有人用退火策略逐渐减小学习率。但这需要提前定义策略,并且没有任何策略是可以适用各种不同的数据集的。3.模型中不同的参数,对应的特征在样本中出现的频次差异很大,因此需要不同的学习率。4.梯度下降的更新完全依赖梯度,因此在梯度几乎为零的鞍点,参数将无法更新。 基于梯度下降的优化器

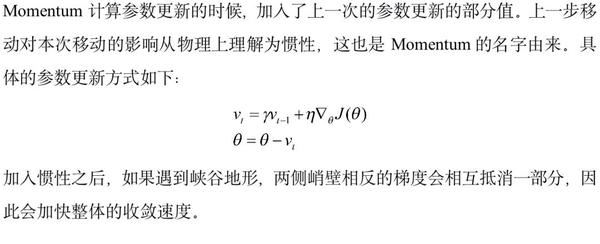

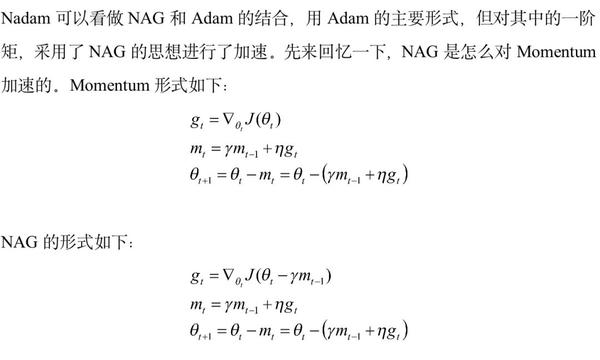

Momentum

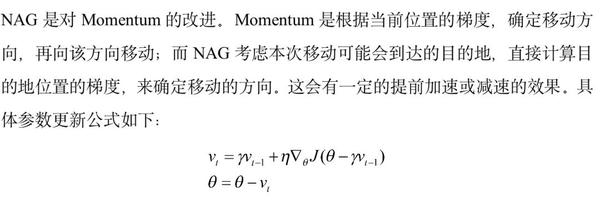

Nesterov accelerated gradient

Adagrad

Adadelta

RMSprop

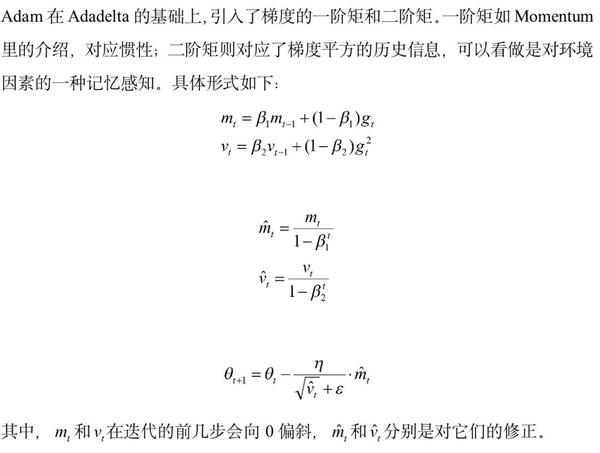

Adam

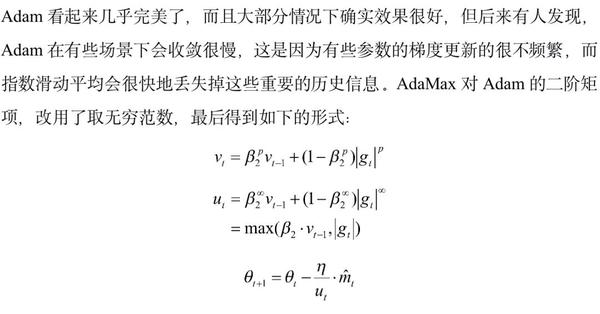

AdaMax

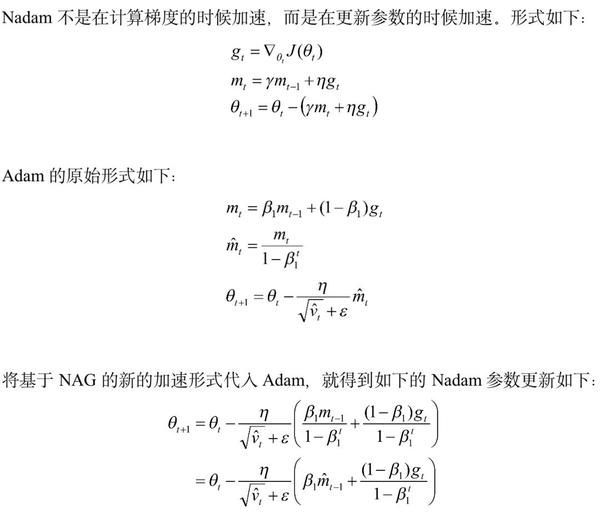

Nadam (NAG+Adam)

AMSGrad (Adam+Max)

本文是对离线优化器的简单介绍,希望对大家能有所帮助。个中疏漏和错误之处,还望大家不吝批评指正。下篇文章会接着介绍一下在线常用的优化器,敬请关注。

-end-